parametro /pa’rametro/ s. m. [dal fr. paramètre,

comp. di para-² e -mètre «-metro»].

1. (matem.) [costante arbitraria da cui dipende

l’andamento di una funzione]. 2. (fig.)

[concetto che sta alla base di una valutazione:

giudicare la situazione secondo p. diversi] ≈

criterio, metro, misura, principio, valutazione.

‖ canone, metodo, regola.

[Treccani, 2016]

1. INTRODUCTION

Le terme paramétrique trouve ses racines dans les mathématiques, en particulier dans les équations dites littérales (ou paramétriques), dont les variables, contrairement à celles des équations numériques, sont exprimées en fonction d’un ou plusieurs paramètres. Grâce à l’application de ces équations, Galilée, à la fin du XVIe siècle, a réussi à quantifier le mouvement en le décrivant à l’aide de lois mathématiques, toujours valides aujourd’hui, qui relient le temps et l’espace en tant que paramètre et variable respectivement.

À une époque plus récente, toutefois, le terme paramétrique a été introduit dans l’architecture par certains ingénieurs et architectes comme un label leur permettant de s’identifier et de différencier leur travail d’autres styles ou mouvements. Bien que la proposition de Patrick Schumacher d’adopter le terme “Parametricisme” remonte à la Smart Geometry Conference de Gothembourg en 2007 (Schumacher, The Autopoiesis of Architecture, vol. 1, 2010), une production architecturale qualifiable de paramétrique a des racines bien plus anciennes.

Aujourd’hui, l’architecture paramétrique est souvent associée à l’intégration de stratégies de conception inspirées de processus numériques et à l’utilisation de logiciels avancés. Ces deux disciplines sont désormais si étroitement liées que leurs frontières en deviennent presque indistinctes. Cependant, cette conception ne reflète pas la réalité pour de nombreux architectes et ingénieurs qui ont utilisé les mêmes processus logiques bien avant l’ère numérique. L’ordinateur n’a fait qu’accélérer ces processus, permettant la création d’architectures dont les formes résultent uniquement d’un processus algorithmique basé sur de multiples paramètres.

Parmi les pionniers de l’utilisation de ces méthodes, on retrouve Antoni Gaudí, Luigi Moretti, Sergio Musmeci, Buckminster Fuller, Heinz Isler et Frei Otto. Ce qui les unit, c’est leur recours aux mathématiques paramétriques et aux modèles physiques pour anticiper les différentes configurations d’espaces et de structures, en réponse à un problème rigoureusement formulé. C’est grâce à ces exemples que l’on peut encore aujourd’hui distinguer une architecture fondée sur un processus solide d’un simple exercice de style informatique purement formel.

Jusqu’aux années 1980, l’architecture paramétrique n’était pas encore considérée comme une pratique architecturale à part entière. Cependant, avec l’arrivée des premiers ordinateurs dans les bureaux d’ingénierie et d’architecture, elle a commencé à se définir progressivement. Ces machines ont offert un avantage considérable en accélérant de façon exponentielle des tâches complexes, comme les calculs structurels, ouvrant ainsi la voie à ce que l’on appelle aujourd’hui l’architecture numérique.

Parmi les premiers architectes à avoir fait de l’architecture numérique leur signature, on trouve Ben Van Berkel, Ron Arad, Hani Rashid (Asymptote Studio) et Lars Spuybroek (Groupe NOX), dont le travail reste emblématique à ce jour. À mi-chemin entre l’architecture numérique et analogique, des figures contemporaines comme Peter Eisenman se démarquent en s’éloignant du processus traditionnel de définition des formes architecturales, et en privilégiant une approche basée sur des diagrammes et une logique vectorielle-informatique

1. INTRODUZIONE

Il termine parametrico affonda le proprie radici nella matematica, in particolare in quelle equazioni dette letterali (o parametriche) le cui variabili, al contrario di quelle delle equazioni numeriche, sono espresse in funzione di uno o più parametri. Tramite l’applicazione di queste equazioni, Galielo Galilei, alla fine del Cinquecento, riuscì nel proprio intento di quantificare il moto descrivendolo con leggi matematiche, tutt’ora valide, che mettono in relazione il tempo e lo spazio rispettivamente come parametro e variabile.

In epoca recente, tuttavia, il termine parametrico è stato introdotto anche in architettura da alcuni ingegneri e architetti come etichetta con la quale identificare sé stessi e differenziare il proprio operato da altri stili o movimenti. Anche se la proposta avanzata da Patrick Schumacher di adozione del termine “Parametricismo” risale alla Smart Geometry Conference a Gothemburg del 2007 (Schumacher 2010, The Autopoiesis of Architecturevol.1), una produzione architettonica definibile parametrica ha radici ben più remote.

L’architettura parametrica viene oggi associata alla pratica di ispirare la strategia di progetto attraverso processi digitali ed all’utilizzo di computer e software complessi, al punto che ormai le due discipline risultano così strettamente correlate da rendere quasi indistinguibili i rispettivi confini; ciò tuttavia non è valido per la moltitudine di architetti ed ingegneri che hanno fatto largo uso dei medesimi procedimenti logici, che il calcolatore ha unicamente la facoltà di accelerare, e che permettono di produrre architetture le cui forme dipendono esclusivamente dal risultato di un processo algoritmico generato da molteplici parametri.

Tra i pionieri dell’utilizzo di questi metodi spiccano figure come Antoni Gaudì, Luigi Moretti, Sergio Musmeci, Buckminster Fuller, Heinz Isler e Frei Otto. Comune a tutti loro è l’impiego della matematica parametrica e dei modelli fisici di studio per determinare a priori le varie configurazioni di spazi e strutture, come risultato di un problema ben formulato. È quindi soprattutto grazie a questi esempi che oggi è ancora possibile distinguere un’architettura guidata da un processo solido da un esercizio di stile informatico e6puramente formale.

Quella che fino agli anni ’80, quindi, non era ancora considerata come una pratica architettonica a sé stante, inizia a delineare i propri caratteri con l’avvento dei primi computer, che compaiono negli studi di ingegneria e architettura più importanti. L’enorme vantaggio di queste macchine fu quello di velocizzare esponenzialmente compiti complessi come ad esempio i calcoli strutturali, aprendo di fatto le porte a quella che oggi viene definita come architettura digitale.

Ben Van Berkel, Ron Arad, Hani Rashid (Asymptote Studio) e Lars Spuybroek (Gruppo NOX) furono tra i primi architetti a fare dell’architettura digitale la propria firma, rimasta tale fino ad oggi. A metà strada tra architetti “digitali” ed “analogici” si delineano quelle figure contemporanee come Peter Eisenman, che prende le distanze dal processo di definizione delle forme dell’architettura, guidandole invece l’utilizzo dei diagrammi secondo una logica vettoriale-informatica.

2 LES ORIGINES DE L’ARCHITECTURE PARAMÉTRIQUE

La méthode développée par Gaudí, bien qu’elle puisse être considérée comme l’exemple le plus important d’utilisation des mathématiques paramétriques au XIXe siècle, a été précédée par quelques cas où les équations paramétriques ont été utilisées pour optimiser la résolution d’un problème.

L’un des premiers exemples notables est celui de James Dana, minéralogiste et géologue du XIXe siècle. Dans son ouvrage On the Drawing of Figures of Crystals (Dana, 1837), il décrit un processus “étape par étape” reliant divers points géométriques pour dessiner des formes cristallines tridimensionnelles et leurs variations, en les définissant à l’aide de paramètres, variables et proportions. Toutefois, bien qu’il ait largement recours à ces notions, Dana n’emploie pas le terme paramétrique dans un sens autre que purement mathématique.

L’exemple le plus significatif du XIXe siècle, comme mentionné précédemment, reste sans aucun doute Antoni Gaudí, principal représentant du modernisme catalan. Grâce aux recherches minutieuses de Mark Burry, architecte en charge de l’achèvement de la Sagrada Família, il a été possible de mieux comprendre les méthodes utilisées par Gaudí pour concevoir une œuvre aussi monumentale. En plus de ses études en architecture, Gaudí possédait une solide formation en mathématiques avancées, physique et ingénierie. Il s’est particulièrement intéressé à l’étude de la chaînette, une courbe qui ressemble à la forme prise par une corde suspendue à ses extrémités sous l’effet de son propre poids.

L’arc caténaire, qu’il a systématiquement employé, suit la géométrie de ces courbes particulières. Lorsqu’elles sont mises en miroir sur l’axe horizontal, ces formes permettent une répartition homogène des charges, générant exclusivement des efforts de compression, ce qui élimine le besoin de contreforts ou de structures de soutien supplémentaires. C’est cette analogie avec une chaîne réelle qui a permis à Gaudí de créer de grands modèles physiques pour évaluer le comportement structurel de ses bâtiments dans leur ensemble.

Grâce à un processus itératif, en modifiant la disposition des chaînes suspendues, Gaudí pouvait définir les espaces tout en vérifiant simultanément la stabilité de la structure. Ce principe de “propagation des modifications” est à la base des systèmes paramétriques modernes, où tout changement apporté à un élément se répercute logiquement sur l’ensemble.

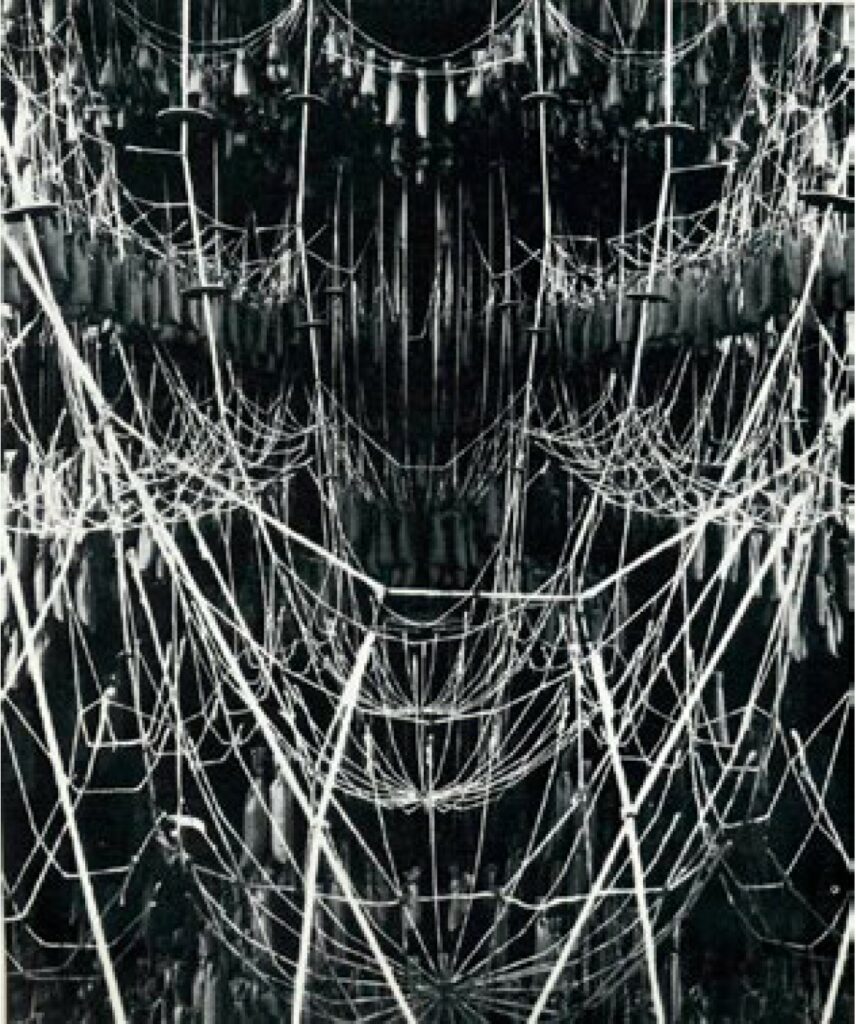

En parallèle des modèles physiques, Gaudí utilisait également des modèles mathématiques constitués d’équations paramétriques afin de garantir la rigueur de ses démarches et de ses résultats. L’un des exemples les plus emblématiques est son étude pour les différentes versions de la chapelle de la Colònia Güell. Des photographies témoignent d’un modèle tridimensionnel inversé de la structure, basé sur un réseau de cordes suspendues.

Ce modèle fonctionne exactement comme une équation paramétrique : un ensemble de paramètres indépendants (longueur des cordes, poids, position des points d’ancrage) génère un ensemble de variables dépendantes (positions des points le long des cordes) régies par les lois de Newton.

En modifiant ces paramètres, Gaudí a pu générer différentes versions de la chapelle, tout en garantissant que la structure reste en pure compression, créant ainsi un système auto-adaptatif semblable aux systèmes paramétriques informatiques modernes.

2 LE ORIGINI DELL’ARCHITETTURA PARAMETRICA

Il metodo sviluppato da Gaudì, anche se può considerarsi l’esempio più importante di utilizzo di matematica parametrica dell’Ottocento, è preceduto da alcuni esempi che fanno uso delle equazioni parametriche per ottimizzare la soluzione ad un problema.

James Dana, mineralogista e geologo vissuto nella metà dell’Ottocento, nel proprio libro On the Drawing of Figures of Crystals (Dana, 1837) illustra un processo “passo-passo” di relazione tra vari punti geometrici per disegnare forme cristalline tridimensionali e le relative variazioni, definendolo con parametri, variabili e proporzioni. Dana tuttavia, nonostante ne faccia largo uso, non utilizza il termine parametrico in un senso diverso da quello prettamente matematico.

L’esempio sicuramente più significativo dell’Ottocento, come già detto, è rappresentato da Antoni Gaudì, il maggior esponente del modernismo catalano. Grazie all’opera meticolosa di ricerca di Mark Burry, attuale architetto esecutivo incaricato di completare la Sagrada Familia, è stato possibile conoscere i metodi che Gaudì utilizzò per la progettazione di un’opera così imponente. Egli infatti oltre gli studi di architettura aveva solide basi di matematica avanzata, fisica ed ingegneria. Si concentrò in particolar modo sullo studio della catenaria, una curva che assomiglia alla configurazione che assume una fune appesa ai due estremi e soggetta al peso proprio.

L’arco catenario, che Gaudì impiegò sistematicamente, è la struttura che segue l’andamento di queste particolari curve che, se riflesse sull’asse orizzontale, subiscono una ripartizione del carico omogenea che genera sforzi in pura compressione, eliminando la necessità di contrafforti od ulteriori strutture di supporto. È proprio l’analogia con la fune reale che permise a Gaudì di creare enormi modelli di studio grazie ai quali fu in grado di valutare il comportamento strutturale dell’edificio nella sua interezza.

Tramite un processo iterativo, cambiando la disposizione delle funi, era possibile per l’architetto determinare gli spazi e contemporaneamente verificare la stabilità della struttura. Questo metodo di “propagazione delle modifiche” è alla base dei moderni sistemi parametrici, nei quali ogni modifica in qualsiasi punto si riflette secondo una certa logica su tutto l’insieme.

Gaudì, affiancava parallelamente ai modelli fisici una serie di modelli matematici composti da equazioni parametriche per verificare la rigorosità dei procedimenti e dei risultati. Risulta emblematico lo studio per le varie versioni della cappella della Colonia Guell, del quale vi sono testimonianze fotografiche del plastico tridimensionale ribaltato della struttura;

il modello della fune appesa ha infatti tutte caratteristiche di un’equazione parametrica: un insieme di parametri indipendenti (lunghezza delle funi, peso, posizione dei punti di ancoraggio) danno origine ad un insieme di variabili (il luogo dei punti situati lungo le funi) in funzione delle leggi di Newton. Modificando i parametri indipendenti Gaudì poté generare diverse versioni della cappella con la certezza che la struttura fosse sempre sollecitata in pura compressione, creando di fatto un sistema auto rigenerativo del tutto simile ai moderni sistemi parametrici informatici.

3 LES ANNÉES 1940

Les années 1940 marquent les premières véritables expérimentations en architecture paramétrique, tant sur le plan formel que structurel, notamment grâce au travail de l’architecte Luigi Moretti et de l’ingénieur Sergio Musmeci.

Moretti, fervent critique de l’inadéquation des théories architecturales modernes et postmodernes face à la complexité du monde et aux défis que l’architecture doit relever, considère que l’approche formelle rigide et figée ne permet pas de résoudre ces problématiques de manière satisfaisante. Il affirme que l’architecture doit naître d’une série de paramètres quantifiables, reliés entre eux par un processus logique et rigoureux. Pour la première fois, le processus génératif de la forme devient le cœur du projet et son unique moteur.

Poursuivant cette idée, Moretti fonde en 1957 l’IRMOU (Istituto per la Ricerca Matematica ed Operativa applicata all’Urbanistica), où il mène un travail de recherche intensif sur l’application des mathématiques à l’architecture. Sergio Musmeci, suivant la même logique, développe les premières études sur les structures en béton armé, en adoptant une approche où la forme est considérée comme une inconnue. Grâce à des outils mathématiques complexes et à l’étude des surfaces minimales, il formule la problématique de l’analyse structurelle en termes d’équations paramétriques. La résolution de ces équations donne lieu à plusieurs solutions valables, rompant ainsi avec la méthode classique consistant à dimensionner et vérifier une structure de manière répétitive. Musmeci défend l’idée que la science des constructions devrait développer une théorie propre des formes, indépendante des méthodes conventionnelles trop rigides des manuels d’ingénierie.

Ce qui unit Moretti et Musmeci, c’est leur conviction que la valeur de l’architecture ne réside pas dans la définition a priori des formes, mais dans la juste définition des relations entre espaces et éléments, en fonction de paramètres objectivement mesurables et quantifiables. Cette approche transforme l’architecture en un processus scientifique et mathématique, sans pour autant en altérer la dimension créative.

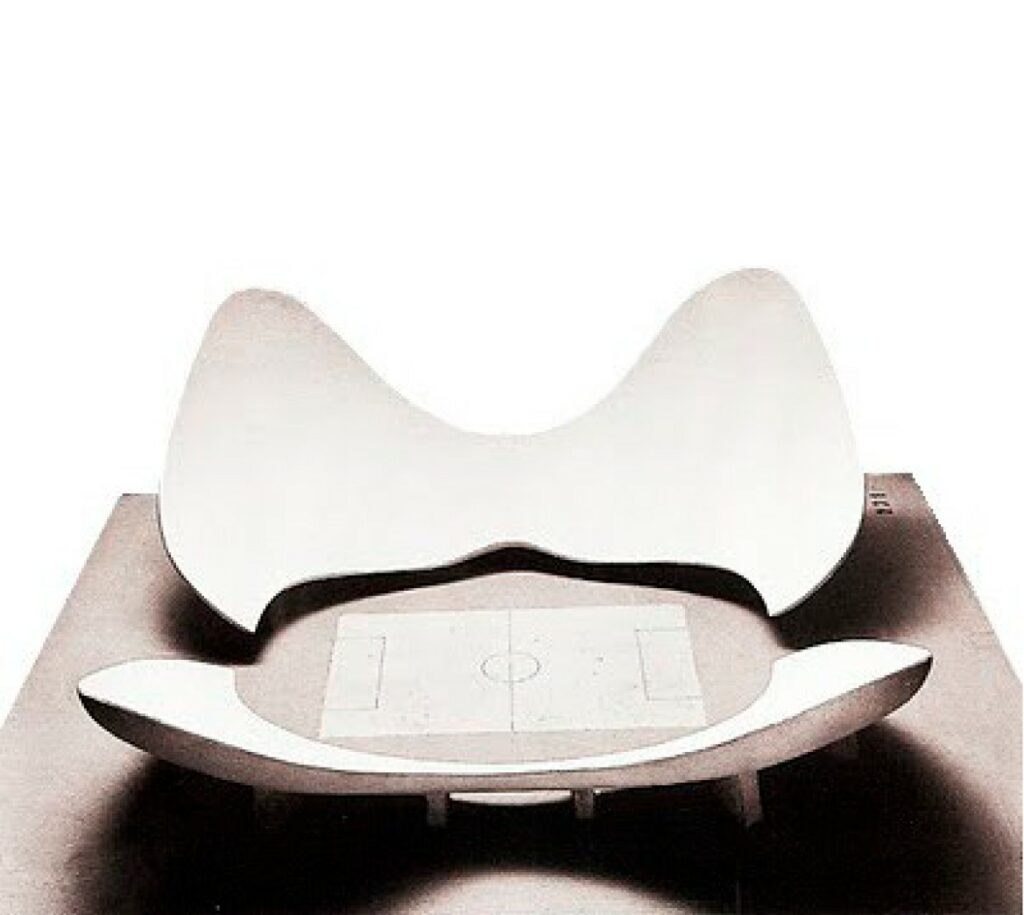

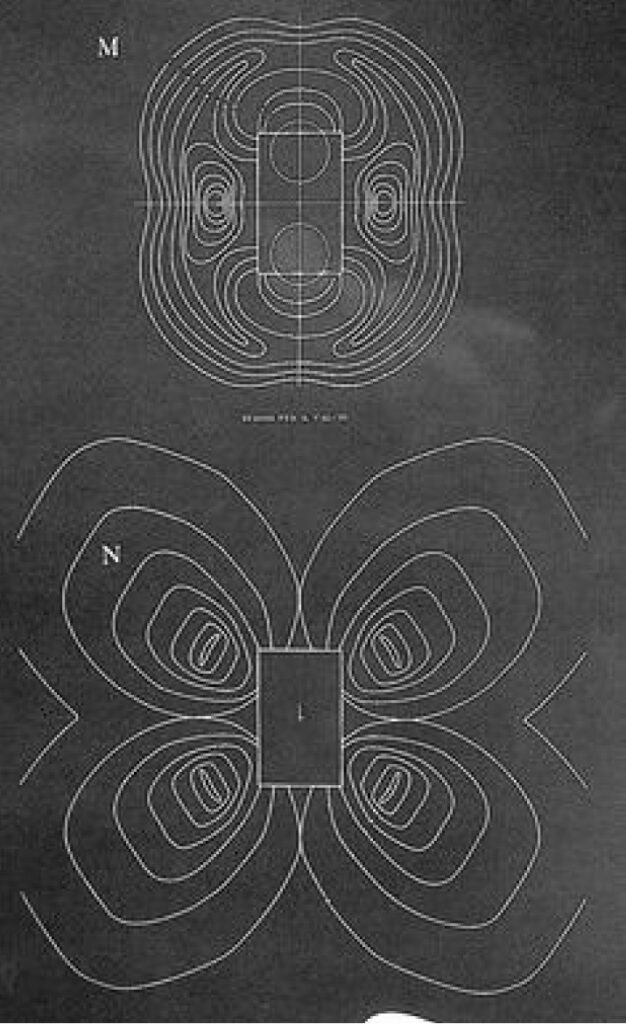

L’un des projets les plus emblématiques de Luigi Moretti est son prototype de stade, présenté à la douzième Triennale de Milan en 1960. En collaboration avec des mathématiciens, il élabore un modèle intégrant dix-neuf paramètres (allant du champ de vision optimal de chaque spectateur au coût de construction des structures en béton armé). Les variations de ces paramètres génèrent une série de courbes définissant la “topologie” de la structure du stade.

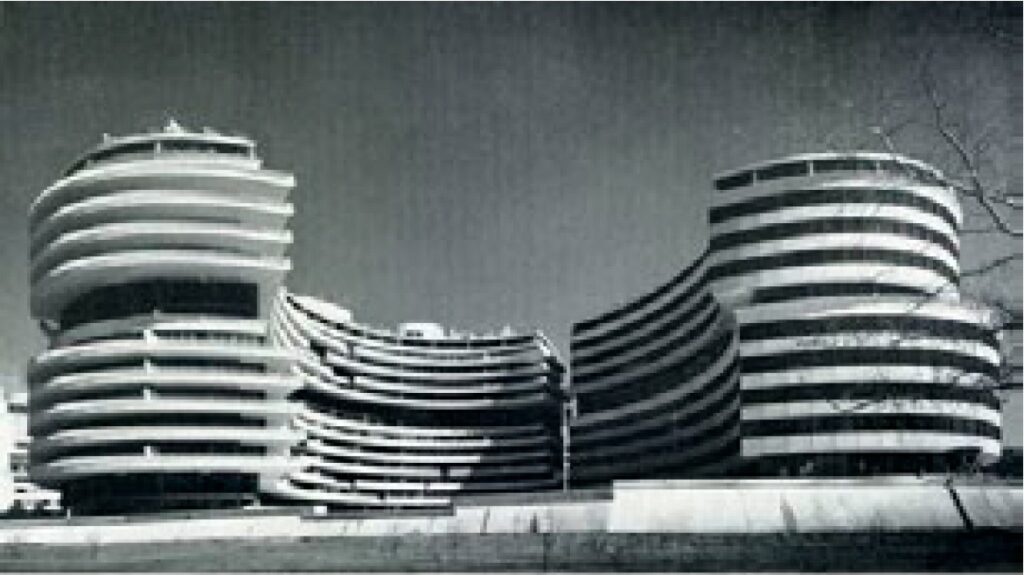

Le Watergate Complex de Washington D.C., également conçu en 1960, constitue un autre exemple de la méthodologie de Moretti. Contrairement au stade, ce projet est réalisé grâce à l’usage de coûteux ordinateurs et à l’intervention de spécialistes en informatique. Il peut ainsi être considéré comme l’une des premières constructions où le numérique joue un rôle fondamental.

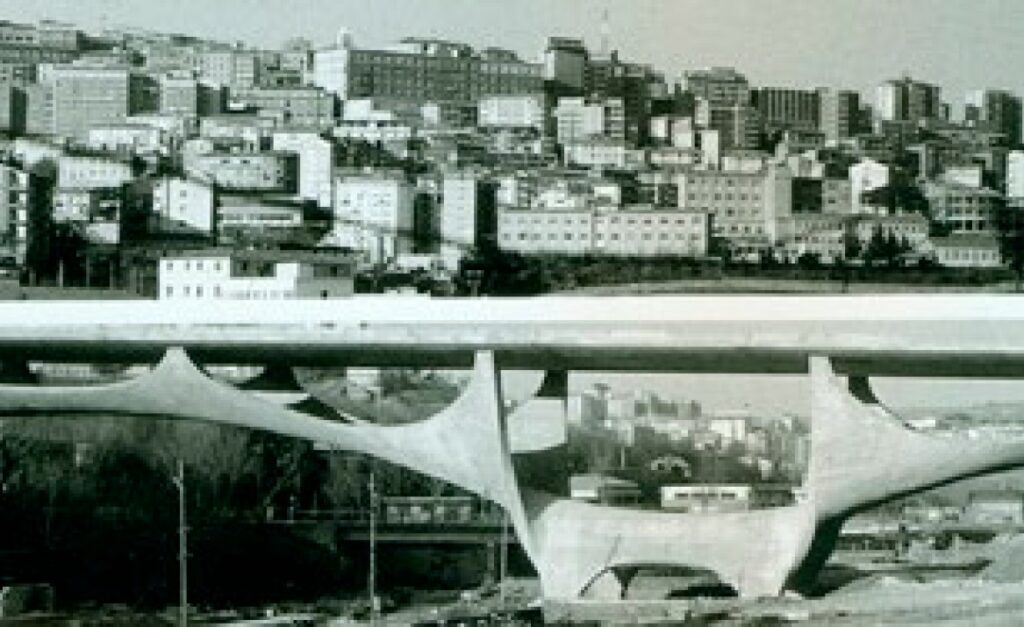

De son côté, Sergio Musmeci réalise en 1967 l’un de ses ouvrages les plus marquants : le pont sur le Basento à Potenza. Sa structure en béton armé est conçue en suivant la forme qu’adopterait un tissu tendu, permettant une distribution optimale des forces.

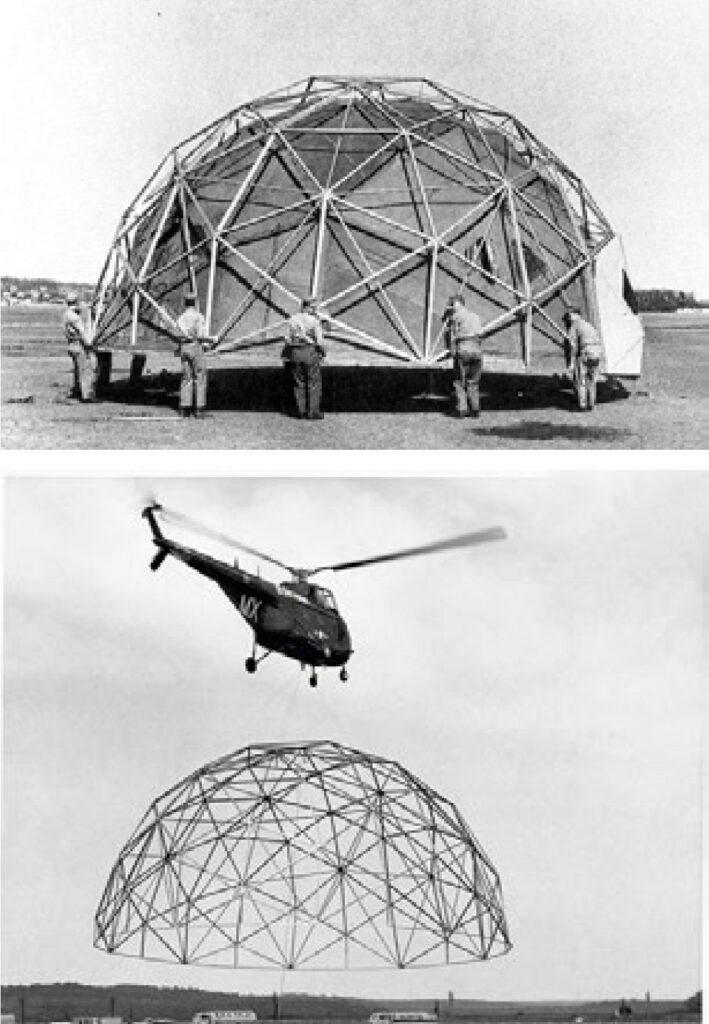

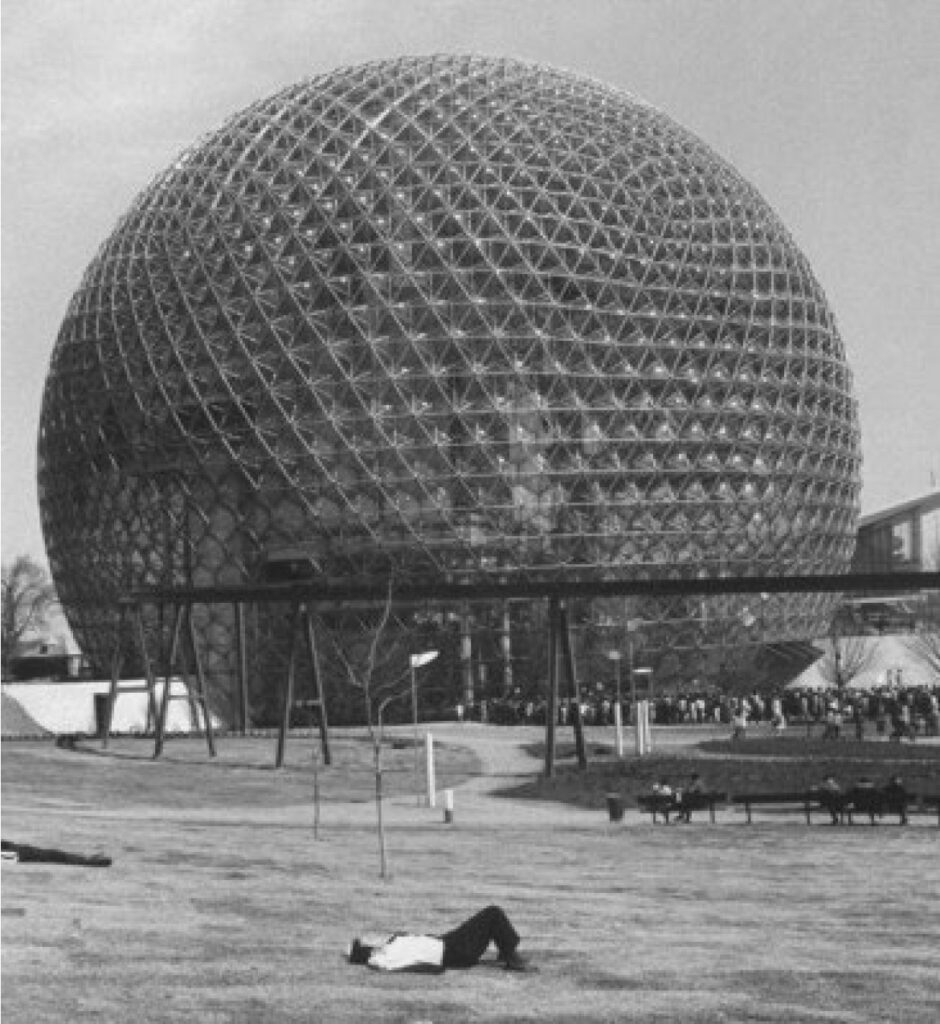

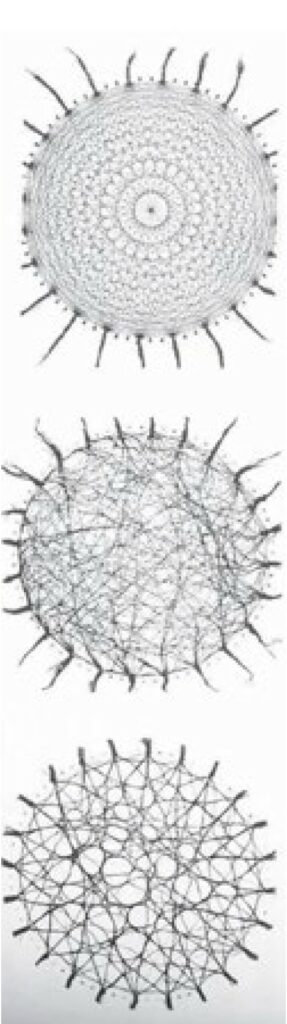

Toujours dans les années 1940, aux États-Unis, Richard Buckminster Fuller entame ses recherches dans un petit collège de Caroline du Nord. C’est là qu’il développe la coupole géodésique, une structure dont l’originalité réside dans le rapport entre sa taille et sa résistance : lorsque la dimension augmente, la résistance augmente proportionnellement. Ce phénomène est rendu possible par la discrétisation de la coupole en triangles équilatéraux, qui, bien que plus nombreux à mesure que la structure grandit, conservent toujours la même taille.

La coupole de Fuller est considérée comme la structure ayant le meilleur rapport poids/volume. Son efficacité et sa grande adaptabilité séduisent l’armée américaine, qui en fait construire plusieurs milliers. Dans ce cas précis, le modèle géodésique paramétrique permet de modifier la taille sans altérer l’intégrité structurelle, générant ainsi différentes configurations valides.

3 GLI ANNI ‘40

Gli anni ’40 vedono nascere i primi veri esperimenti di architettura parametrica, sia a livello formale sia strutturale, ad opera soprattutto dell’architetto Luigi Moretti e dell’ingegnere Sergio Musmeci.

Il primo, fervido sostenitore dell’inadeguatezza della teoria architettonica moderna e postmoderna nell’interpretazione della complessità del mondo e dei problemi a cui l’architettura deve fornire risposte concrete, impossibili da risolvere adeguatamente con una pratica architettonica così rigida e formalista, asserisce che l’architettura debba nascere da una serie di parametri quantizzabili messi in relazione tra loro con un processo logico e rigoroso; il procedimento che genera la forma dell’edificio diventa per la prima volta il fulcro del progetto ed unico generatore.

A dimostrazione della propria tenacia, Moretti, nel 1957, fondò l’IRMOU (Istituto per la Ricerca Matematica ed Operativa applicata all’Urbanistica) svolgendo un intenso lavoro di ricerca sull’applicazione della matematica in architettura. Sergio Musmeci, seguendo la stessa logica, inizia gli studi per le prime strutture in calcestruzzo armato con la filosofia della ‘forma come incognita’; avvalendosi di complessi strumenti matematici abbinati allo studio delle superfici minime, egli pone il problema dell’analisi strutturale in termini di equazioni parametriche, la cui risoluzione porta a diverse soluzioni egualmente valide, prendendo la distanza dal classico procedimento ripetitivo di dimensionamento e verifica. Egli sosteneva che la scienza delle costruzioni dovesse sviluppare una propria teoria delle forme, distaccandosi dai metodi obsoleti e troppo limitanti riportati nei manuali.

Ciò che accomuna questi due personaggi è la convinzione che il valore dell’architettura non risieda nella definizione delle forme a priori, ma piuttosto, nella corretta definizione delle relazioni tra spazi e singoli elementi, dipendenti da parametri descrivibili e quantizzabili oggettivamente, rendendola di fatto un processo matematico e scientifico ma non meno creativo.

Un esempio perfetto dell’opera e del pensiero di Luigi Moretti è il prototipo dello stadio prodotto per la dodicesima Triennale di Milano del1960. In collaborazione con alcuni matematici, sviluppò un modello che mette in relazione ben diciannove parametri (dal campo visivo ottimale di ogni spettatore al costo di esecuzione delle opere in cemento armato) la cui variazione genera una serie di curve che rappresentano la “topologia” della struttura dello stadio.

Il Watergate Complex di Washington D.C., sempre del 1960, è un ulteriore esempio della pratica architettonica di Moretti basata sulla definizione di parametri, con la differenza che questo venne effettivamente realizzato con l’aiuto di costosissimi calcolatori e l’impiego di esperti informatici; quest’ultima può essere considerata tra le primissime costruzioni in cui il computer ha giocato un ruolo fondamentale.

La progettazione dell’opera più significativa di Sergio Musmeci risale invece al 1967: il Ponte sul Basento a Potenza. La struttura è realizzata in cemento armato plasmato secondo la forma che assumerebbe un “tessuto teso” che permette la miglior distribuzione possibile delle forze.

Risalente sempre agli anni ’40, in America, è l’inizio dell’attività di Richard Buckminster Fuller come ricercatore in un piccolo college in North Carolina dove sviluppò la cupola geodetica. La peculiarità di questa struttura è il rapporto tra dimensioni e resistenza: all’aumentare della prima aumenta proporzionalmente la seconda. Questo fenomeno è reso possibile dal metodo di discretizzazione della cupola in elementi triangolari equilateri che aumentano di numero all’aumentare delle dimensioni della struttura nel complesso ma non modificano la propria dimensione.

La struttura di Fuller è considerata quella con il più favorevole rapporto peso/volume racchiuso, al punto che l’esercito americano, constatandone la versatilità, ne fece costruire migliaia. In questo caso, il modello della cupola geodetica permette di modificare il parametro della dimensione senza alterare l’integrità della struttura, restituendo quindi diversi output sempre validi.

4 LES ANNÉES 1950 : ANALOG COMPUTING

Les années 1950 voient émerger les premières tendances postmodernes, en opposition avec la rigide philosophie du Mouvement Moderne. Des figures comme Robert Venturi et Denise Scott Brown popularisent des slogans tels que « Less is a Bore » (Moins, c’est ennuyeux), tandis que Peter Blake tourne en dérision l’adage moderniste « Form follows function » en le transformant en « Form follows Fiasco » (La forme suit le fiasco). Dans ce climat de rejet des principes du Mouvement Moderne et de l’International Style, naissent les premières œuvres de Frei Otto et Heinz Isler.

Ces deux pionniers s’éloignent des canons traditionnels, y compris ceux du postmodernisme, en développant une approche de « Form Finding » (recherche de forme) qui rappelle les méthodes employées par Antoni Gaudí.

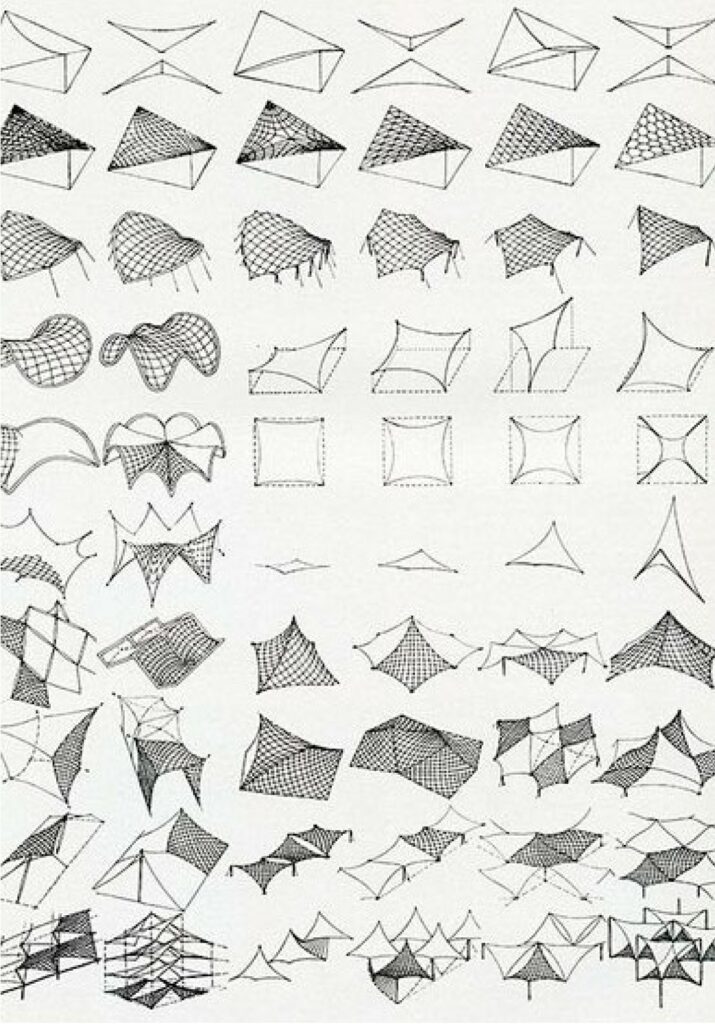

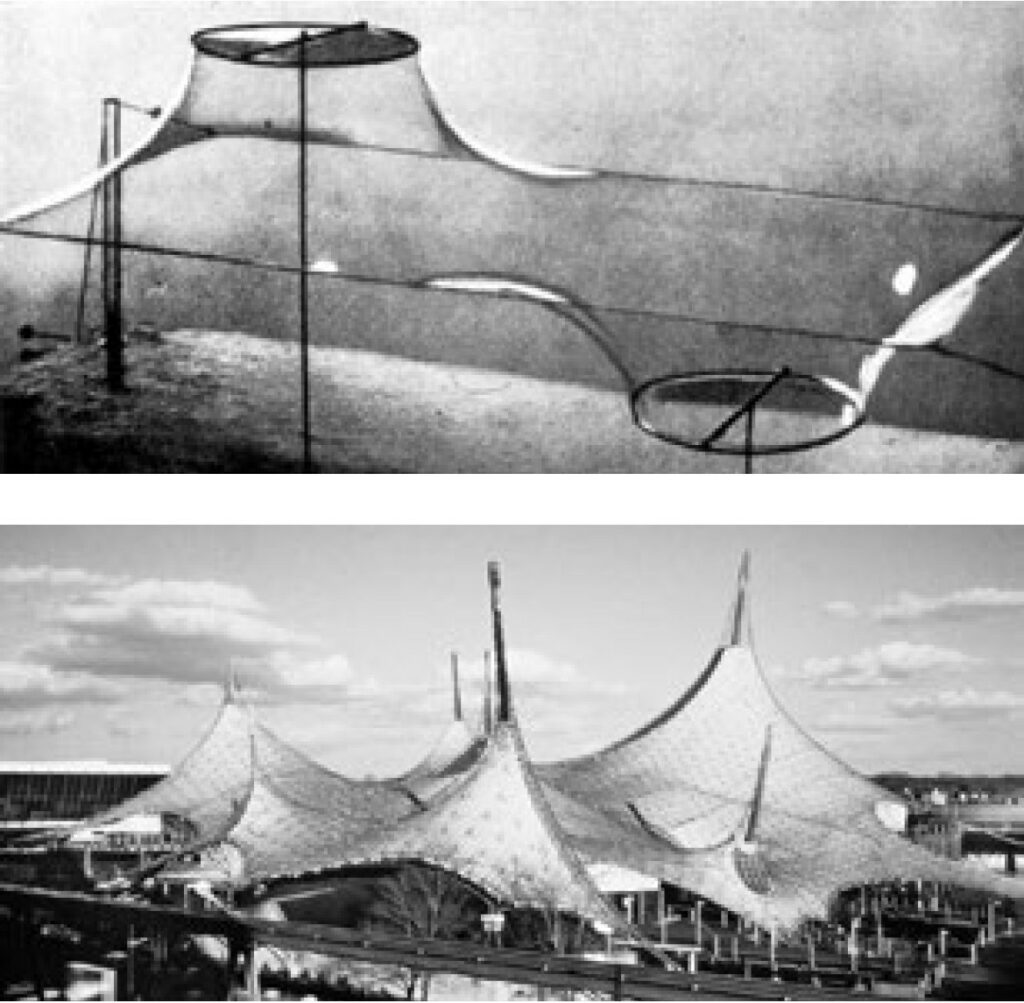

Architecte de formation, Frei Otto est l’un des plus grands spécialistes des surfaces minimales. Ces dernières sont définies comme des surfaces reliant deux ou plusieurs courbes fermées, en adoptant une configuration où l’aire est minimisée et où la courbure moyenne est nulle en tout point. Une telle disposition permet un équilibre parfait des tensions internes.

La théorie des surfaces minimales remonte à 1792, lorsque Lagrange publie son essai « Essai d’une nouvelle méthode pour déterminer les maxima et les minima des formules intégrales indéfinies », dans lequel il cherche à définir les équations de la surface minimale entre deux cercles. Un siècle plus tard, autour de 1850, Joseph Plateau approfondit ces études en plongeant des cadres métalliques de différentes formes dans une solution d’eau savonneuse. L’objectif est d’observer la manière dont le savon forme des membranes minimales entre des courbes complexes.

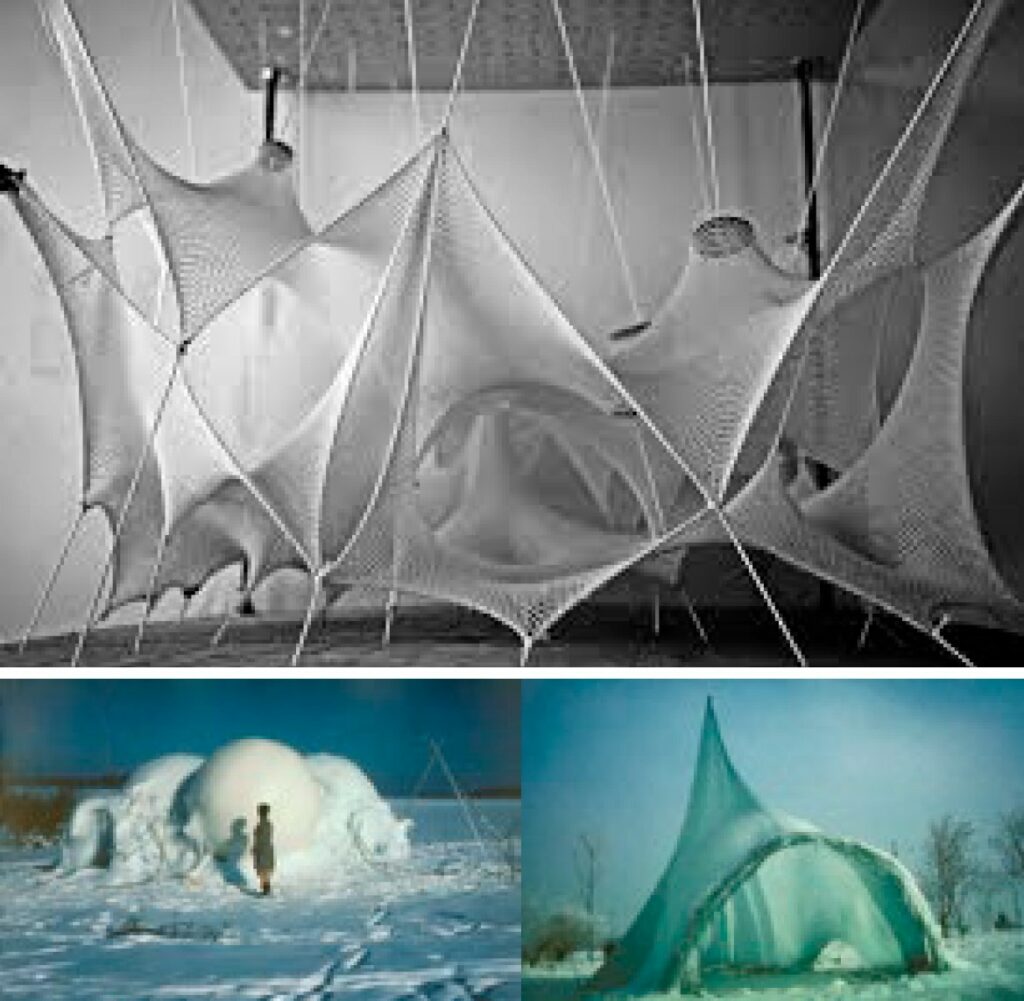

Dans les années 1950, Frei Otto est le premier à transposer cette approche en architecture. Il expérimente avec des films de savon, mais aussi avec des tissus suspendus, des filets tendus et des structures en treillis pour étudier les configurations minimisant les tensions internes.

Il met au point un processus itératif :

Détermination des limites structurelles: en variant la configuration du cadre dans lequel est soufflée la membrane de savon, il identifie la distance maximale entre les bords avant que la structure ne se rompe.

Application aux matériaux architecturaux: en remplaçant le savon par un tissu tendu, il analyse la forme obtenue et l’espace généré.

Cette approche garantit une distribution uniforme des tensions et génère une architecture organique et optimisée, sans que la forme ne soit déterminée à l’avance. Otto définit ce processus avec Bodo Rasch sous le nom de « Form Finding », un principe fondamental de l’architecture paramétrique.

L’ingénieur suisse Heinz Isler, quant à lui, devient célèbre pour ses coques en béton armé. Utilisant des techniques similaires à celles de Frei Otto, il étudie le comportement des structures par l’expérimentation physique, mais avec une approche singulière :

Il suspend des chaînes et des tissus pour observer leur forme naturelle sous traction.

Il congèle ces structures, puis les retourne pour les analyser sous compression, générant ainsi des modèles physiques de coques en béton. Cette technique lui permet de concevoir des structures aux formes inattendues et optimisées, minimisant la matière tout en garantissant une stabilité maximale.

Otto et Isler utilisent tous deux des modèles physiques analogiques pour générer des formes adaptées aux contraintes structurelles et environnementales. Leur méthode repose sur des processus algorithmiques et itératifs, où la forme finale n’est pas prédéfinie, mais résulte naturellement de l’interaction entre des forces et des paramètres physiques.

Aujourd’hui, des logiciels de simulation avancés permettent de reproduire ces mêmes principes dans un environnement numérique, offrant une flexibilité encore plus grande dans l’exploration des formes architecturales.

Leurs travaux sont donc les prémices de l’architecture paramétrique numérique, où la conception est guidée par les lois de la physique et de la géométrie, plutôt que par une intuition purement esthétique.

4 GLI ANNI ’50: ANALOG COMPUTING

Gli anni ’50 videro la nascita delle prime tendenze postmoderne, dichiaratamente in contrasto con la rigida filosofia del Movimento Moderno, coniando frasi come <<Less is a Bore>> di Robert Venturi e Denise Scott Brown e <<Form follows Fiasco>> di Peter Blake, rifiutando anche il celebre saggio ‘Ornament und Verbrechen’ (Ornamento e Delitto) di Adolf Loos del 1908. In questo clima di superamento dei limiti imposti dal Movimento Moderno e dall’International Style, che hanno guidato l’architettura fino a quel momento, nascono le prime opere di Frei Otto e Heinz Isler.

Entrambi prendono le distanze dai normali canoni di progettazione, anche da quelli postmoderni, lavorando con un metodo di “Form Finding” che ricorda quello utilizzato da Antoni Gaudì.

Otto, laureato in architettura, fu uno dei più importanti studiosi delle superfici minime, ossia quelle superfici che “collegano” due o più curve di bordo chiuse, disponendosi secondo una configurazione tale per cui la propria area è minimizzata e la curvatura media è sempre zero in ogni punto. In questa configurazione, le tensioni interne delle strutture sono perfettamente bilanciate.

La teoria delle superfici minime nacque come problema matematico nel 1792 con la pubblicazione del saggio di Lagrange “Essai d’une nouvelle méthode pour déterminer les maxima et les minima des formules intégrales indéfinies”, nel quale egli cerca le equazioni per descrivere la superficie minima tra due circonferenze. Nel 1850 circa, Joseph Plateau ripresegli studi sulle superfici minime utilizzando telai metallici di diverse forme immersi in acqua saponata per studiare le superfici minime tra curve complesse.

Otto, dalla metà del Novecento in poi, fu il primo ad utilizzare questo procedimento per determinare la forma architettonica. Oltre al sapone egli utilizzò drappi, maglie reticolari appese e tessuti tesi per studiare le configurazioni delle minime tensioni ed ottimizzare le strutture dei telai. Egli quindi, modificando le curve “generatrici” poté utilizzare il processo, che definì insieme all’architetto Bodo Rasch ‘Form Finding’, per generare le forme sinuose che la propria architettura. Il primo passaggio era quello di determinare il limite entro cui la superficie non è più bilanciata, messo in atto attraverso lo studio delle superfici di sapone (variando la configurazione del telaio era possibile trovare la distanza massima tra i bordi, oltre la quale la superficie di sapone si disgrega); successivamente applicando al solito telaio un tessuto era possibile valutarne la forma assunta e lo spazio generato da quella particolare configurazione. Anche in questo caso la forma non viene determinata a priori, ma è il risultato di un procedimento che ha come parametro la disposizione reciproca dei punti e delle linee di ancoraggio che determinano la configurazione del materiale utilizzato, assicurando allo stesso tempo una distribuzione uniforme delle tensioni, secondo una logica che si può definire parametrica.

Heinz Isler, ingegnere strutturista svizzero, allo stesso modo, divenne famoso per i suoi “gusci” in cemento armato. Quest’ultimo, mediante dei procedimenti simili a quelli di Otto, studiava la disposizione di catenarie e tessuti appesi, ma congelando letteralmente il materiale per poterlo ribaltare e successivamente studiarne il comportamento a compressione e lo spazio generato, creando delle vere e proprie strutture di ghiaccio compresso. Entrambi i personaggi quindi operarono lasciando alla forma finale dell’edificio il ruolo di risultato, spesso inatteso, generato da un processo algoritmico fisico ed analogico, simile a quello che al giorno d’oggi viene utilizzato grazie a complessi software di simulazione fisica che permettono di studiare gli stessi modelli anche se virtuali.

5 LES ANNÉES 1960 : DIAGRAMMES ET PREMIERS ORDINATEURS

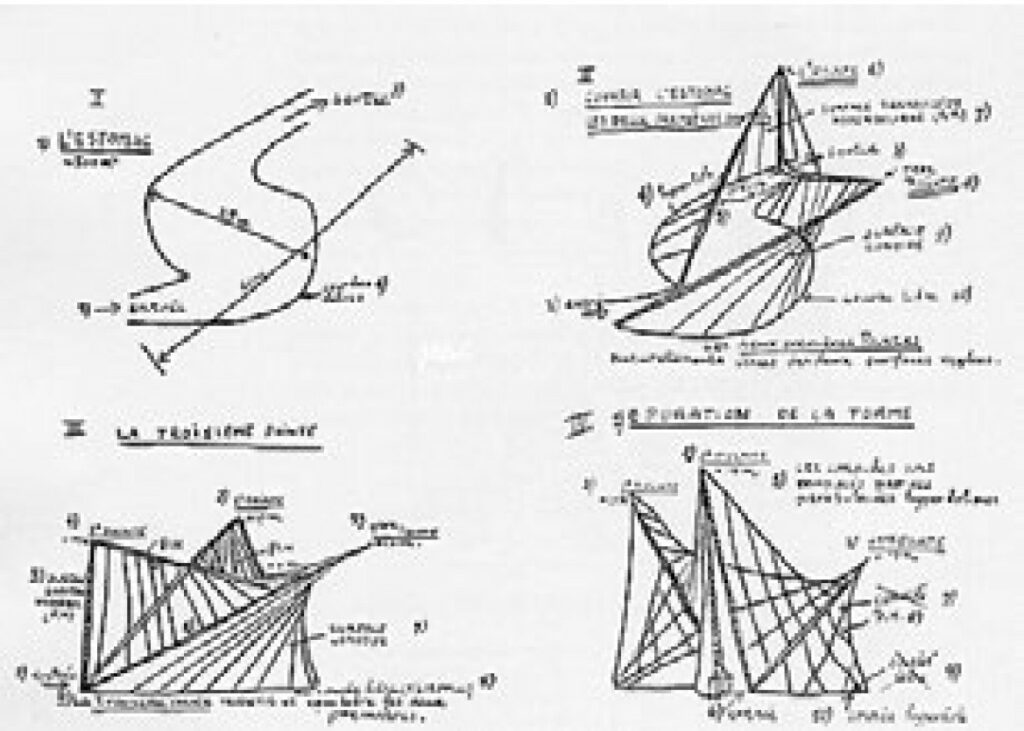

En 1958, la première Exposition universelle après la Seconde Guerre mondiale se tient à Bruxelles, avec pour thème la reconstruction de la civilisation à travers l’utilisation des nouvelles technologies. C’est dans ce contexte que la Philips Electronic Company, alors leader dans le domaine technologique, charge Le Corbusier et Iannis Xenakis de concevoir son pavillon pour l’Expo.

Ce projet est encore aujourd’hui considéré comme particulièrement novateur, tant par son approche conceptuelle que par son processus de conception et son résultat final. Au cœur du pavillon se trouve le “Poème électronique”, une œuvre artistique commandée au compositeur Edgard Varèse, qui combine huit minutes de musique électronique expérimentale, des projections visuelles et des jeux de lumière.

L’architecture du pavillon, majoritairement conçue par Iannis Xenakis, lui-même compositeur et ingénieur, découle directement de cette œuvre musicale. L’espace a été conçu pour accompagner une progression sonore et immersive, où le spectateur est guidé dans une expérience presque organique, comme une sorte de “digestion” sensorielle menant à la salle principale.

Le résultat est une spatialisation du son, obtenue en assemblant neuf paraboloïdes hyperboliques, suivant un algorithme mathématique simple prenant en compte la propagation des ondes sonores. Comme le déclarait Le Corbusier aux commanditaires :

« Je ne ferai pas un pavillon pour vous, mais un Poème électronique et un écrin pour le contenir : lumière, couleur, images, rythme et son fusionnés dans une synthèse organique. »

Ainsi, le pavillon n’est pas simplement une architecture, mais une œuvre où lumière, couleur, image, rythme et son sont intégrés dans un tout organique et indissociable.

Un autre tournant des années 1960 est apporté par Peter Eisenman, qui défend une approche où l’architecture s’affranchit des contingences historiques. Souvent rapproché de figures comme Aldo Rossi ou Giuseppe Terragni, il s’en distingue pourtant par un outil clé dans sa méthodologie : le diagramme.

Pour Eisenman, le diagramme ne se limite pas à un simple outil descriptif ou analytique, mais devient un moteur de conception (« generative device »). Il explique :

« En tant que dispositif génératif dans un processus de conception, le diagramme est aussi une forme de représentation. Mais contrairement aux formes traditionnelles de représentation, le diagramme, en tant que générateur, est une médiation entre un objet palpable – un bâtiment réel – et ce que l’on peut appeler l’intériorité de l’architecture. […] Le diagramme suggère une relation alternative entre le sujet/auteur et l’œuvre. Une telle alternative marque un éloignement de la composition classique et de l’expressionnisme personnel vers un processus plus autonome. »

Tout son travail repose sur ce concept fondamental, qui lui permet d’explorer des formes architecturales autonomes issues d’un processus algorithmique précis. Il distingue deux types de diagrammes : Diagrammes d’intériorité: qui concernent la forme architecturale elle-même.

Diagrammes d’extériorité: qui s’appuient sur des données externes (géographiques, mathématiques, scientifiques, textuelles, etc.).

Ces données sont ensuite transformées à l’aide de trente-neuf outils, dont 25 sont formels et 14 conceptuels. Ces outils ressemblent fortement aux fonctionnalités des logiciels de modélisation paramétrique modernes, comprenant des opérations comme : Extrusion, Intersection, Torsion, Distorsion, Transformation, Désassemblage et Décomposition

Eisenman conçoit ainsi l’architecture comme un processus, où la forme finale n’est pas préétablie, mais émerge d’une série d’opérations prédéfinies, comme un algorithme.

Toutefois, bien qu’il ait recours à des procédés aujourd’hui entièrement implémentables par ordinateur, Eisenman n’est pas considéré comme un architecte numérique. Son approche reste analogique, le processus algorithmique étant réalisé manuellement, l’ordinateur n’étant utilisé qu’à la dernière étape du dessin.

5 GLI ANNI ’60: DIAGRAMMI E PRIMI COMPUTER

Nel 1958 si tenne la prima esposizione universale dopo la seconda guerra mondiale a Bruxelles, il cui tema fu quello della ricostituzione della civiltà, in seguito alla distruzione portata dal conflitto, tramite l’utilizzo della tecnologia. Fu allora che la Philips Electronic Company, al tempo leader nel campo tecnologico, incaricò Le Corbusier e Iannis Xenakis di progettare il proprio padiglione per l’Expo.

Il progetto è considerato estremamente attuale sia per l’approccio progettuale sia per il concetto che vi sta alla base, oltre che ovviamente per il risultato finale. Il fulcro del padiglione era il ‘Poème Electronique’, ossia la composizione artistica la cui creazione fu affidata ad Edgard Varése, che comprendeva otto minuti di musica elettronica sperimentale affiancata da proiezioni video e giochi di luce. L’edificio invece, progettato quasi esclusivamente da Xenakis, compositore oltre che ingegnere, venne plasmato a partire dalla sinfonia musicale, che doveva assumere caratteri differenti man mano che ci si addentrava all’interno, fino alla sala principale, come quasi in un processo di “digestione” dello spettatore.

Il risultato è la spazializzazione del suono, ottenuta fondendo insieme un gruppo di nove paraboloidi iperboliche seguendo un semplice algoritmo matematico che tiene conto della propagazione delle onde sonore. Come lo stesso Le Corbusier dichiarò ai committenti << I will not make a pavilion for You but an Electronic Poem and a vessel containing the poem; light, color images, rhythm and sound joined together in an organic synthesis. >> il padiglione non fu pensato come mera architettura, ma come la fusione in un unico elemento organico di luce, colore, immagine, ritmo e suono.

Un approccio completamente innovativo è rappresentato dall’opera di Peter Eisenman, il quale sostiene la necessità di un’autonomia delle forme architettoniche rispetto alle contingenze storiche; per questo motivo viene spesso affiancato alle figure di Aldo Rossi o Giuseppe Terragni. Eisenman tuttavia, prende le distanze dal processo di definizione della forma attraverso l’utilizzo di uno strumento che egli definisce << […] as old as architecture itself […] >>: il diagramma. Egli non lo considera un semplice strumento descrittivo o analitico ma piuttosto lo definisce “generativo”: «As a generative device in a process of design, the diagram is also a form of representation. But unlike traditional forms of representation, the diagram as a generator is a mediation between a palpable object, a real building, and what can be called architecture’s interiority. […] [the diagram] suggests an alternative relationship between the subject/author and the work. Suchan alternative suggests a movement away from classical composition and personal expressionism toward a more autonomous process.>>

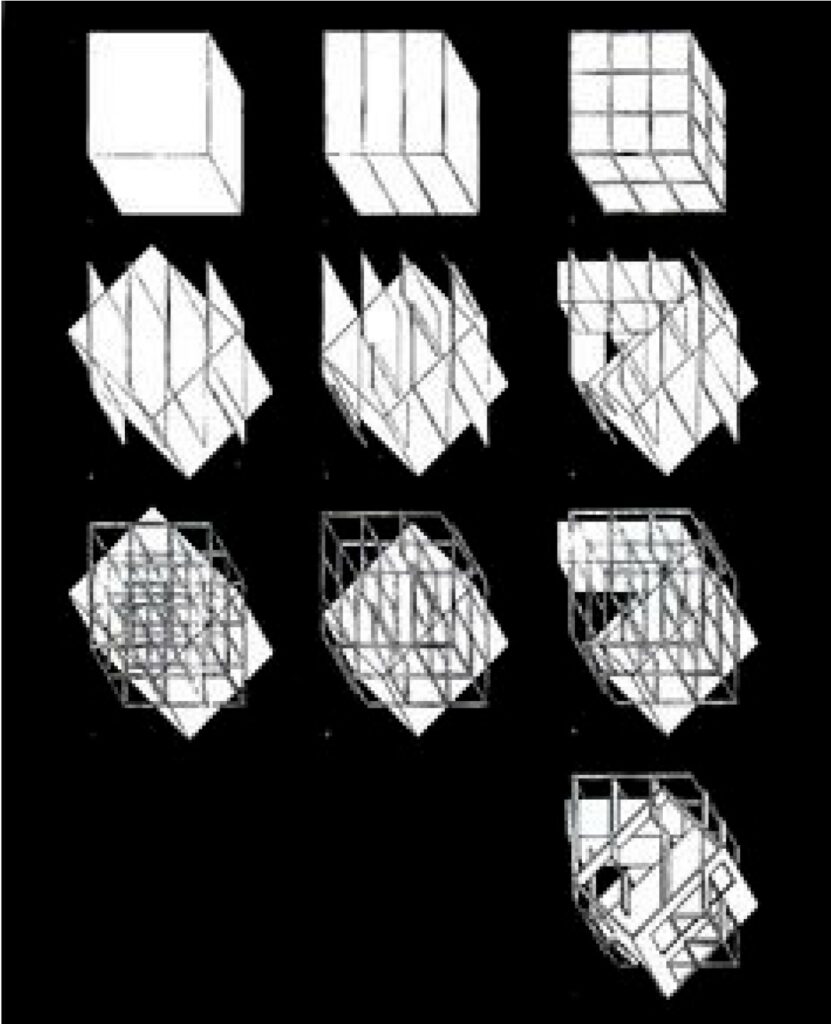

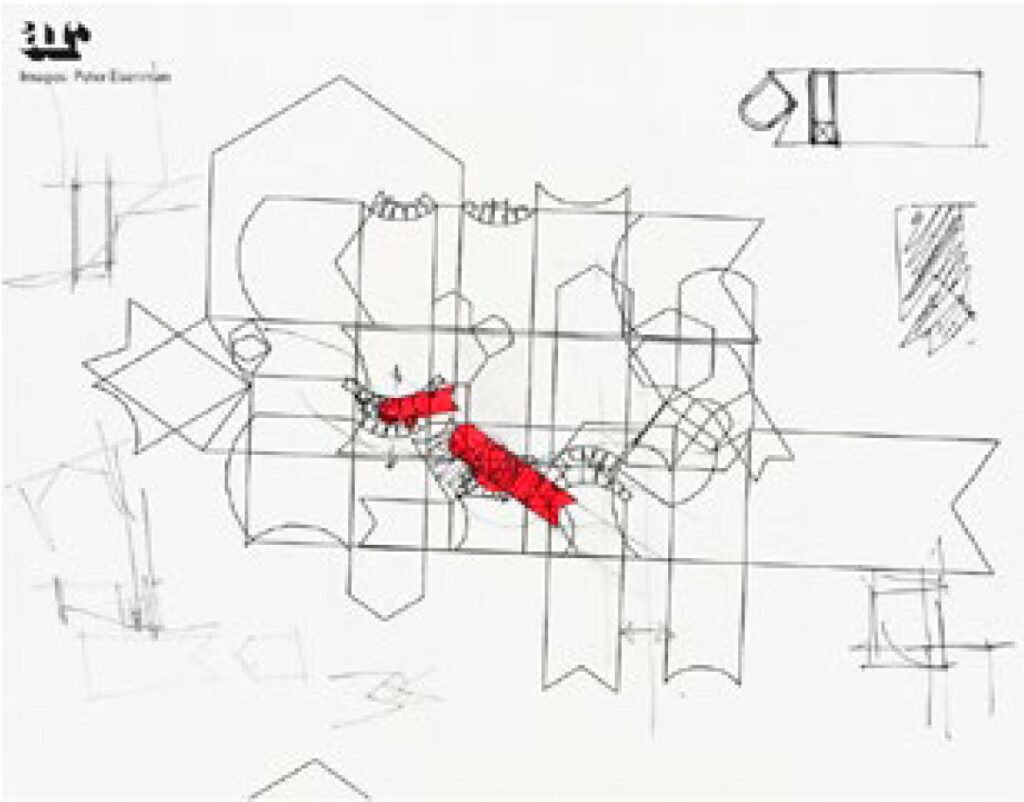

Egli basa l’interezza del proprio operato su questo semplice concetto, definendo due diverse tipologie di diagramma (“diagrams of interiority” e “diagrams of exteriority”), che fanno riferimento rispettivamente alla forma architettonica e ad alcune tipologie di dati (geografici, matematici, scientifici, testuali), modificandoli tramite trentanove “strumenti”(25 “formali” e 14 “concettuali”), del tutto simili agli strumenti disponibili all’interno dei moderni software, parametrici e non, come ad esempio l’estrusione, l’intersezione, la torsione, la distorsione, la trasformazione, il disassemblaggio o la decomposizione. Tramite l’utilizzo di questi componenti egli riesce a prendere le distanze dal progetto formale, che si genera a partire da una serie di operazione definite in precedenza, come un algoritmo. Eisenman, nonostante utilizzi dei procedimenti che al giorno d’oggi sono perfettamente implementabili in un computer, non è conosciuto in quanto architetto digitale, poiché il processo algoritmico da lui creato è di fatto analogico e solamente la stesura ultima del progetto passa, ovviamente, attraverso il pc, utilizzato come puro strumento di disegno.

6 HISTOIRE DE L’ORDINATEUR

L’arrivée de l’ordinateur a provoqué une transformation comparable à la révolution industrielle. Aujourd’hui, presque tout le monde possède un ordinateur, un smartphone ou une tablette, offrant un accès à une puissance de calcul considérable, bien supérieure à celle des premiers calculateurs, qui étaient extrêmement coûteux.

Dans le domaine de l’architecture, cette évolution a eu un impact majeur, bien que son influence ait commencé dès les années 1960, lorsque les premiers cabinets d’architecture ont commencé à expérimenter les outils informatiques.

Ivan Sutherland est considéré comme le pionnier des systèmes de conception assistée par ordinateur. En 1963, il développe Sketchpad, le premier logiciel doté d’une interface graphique permettant le dessin paramétrique, c’est-à-dire la possibilité de maintenir les relations entre les objets même après des modifications.

À partir de cette période, des bureaux comme Skidmore, Owings & Merrill commencent à explorer des approches numériques en architecture. Toutefois, la faible puissance de calcul et le coût élevé des ordinateurs empêchent leur adoption à grande échelle.

Bien qu’il existe déjà des modèles d’ordinateurs dits personnels, c’est IBM qui marque un tournant en 1981 avec le premier ordinateur personnel réellement accessible, grâce à un prix plus abordable et une large gamme d’accessoires.

En 1988, le premier logiciel de modélisation paramétrique, Pro/ENGINEER (aujourd’hui connu sous le nom de PTC Creo), voit le jour. Ce programme permet de définir les relations entre les différents éléments d’un modèle, de préserver les dimensions et les fonctions des objets et de créer des modèles virtuels dynamiques sans nécessiter de tests physiques. Dès lors, l’ordinateur ne se limite plus à un simple outil de dessin, mais devient un véritable accélérateur du processus de conception, capable de fournir aux architectes des informations essentielles sans passer par des maquettes physiques.

Dans les années 1990, Microsoft et Apple démocratisent l’usage des ordinateurs grâce à des systèmes d’exploitation dotés d’interfaces graphiques accessibles au grand public. À partir de ce moment, l’ordinateur devient un outil indispensable pour de nombreux professionnels, amorçant une véritable révolution numérique.

Des architectes comme Frank Gehry, Ben Van Berkel et Lars Spuybroek commencent alors à fonder l’ensemble de leur travail sur l’utilisation de l’informatique. Gehry adopte initialement le logiciel paramétrique CATIA, jusqu’alors réservé à l’industrie aérospatiale, avant de développer une version spécifique adaptée à l’architecture, Digital Projects, mise au point par son entreprise Gehry Technologies.

L’un des principaux obstacles à la diffusion du numérique en architecture, et en particulier à l’architecture paramétrique, demeure la nécessité de maîtriser des langages de programmation complexes pour créer des modèles fonctionnels et concevoir des algorithmes génératifs, sans être limité par des contraintes techniques.

Au cours des années 1990, plusieurs langages de programmation comme Python et Java apparaissent, facilitant l’écriture de code tout en restant puissants. Une avancée majeure dans les logiciels d’architecture se produit en 2003 avec le lancement de Generative Components, le premier programme de “Visual Scripting”. Il permet de travailler sur des opérations et algorithmes personnalisés sans nécessiter une connaissance approfondie de la programmation. Grâce à une interface graphique basée sur l’association visuelle d’éléments contenant des lignes de code basiques, il devient possible de développer un algorithme génératif sans écrire directement du code.

En 2007, le logiciel Explicit History, précurseur de Grasshopper, voit le jour. Il s’agit aujourd’hui de l’un des outils les plus utilisés dans le domaine du Visual Scripting. L’émancipation des contraintes liées à la programmation permet ainsi de gérer de grandes quantités de données, d’optimiser des processus paramétriques complexes et de réaliser des simulations sophistiquées pour générer des formes architecturales.

Cependant, l’accessibilité croissante de ces logiciels entraîne un phénomène de standardisation et de perte d’identité architecturale. L’usage massif de ces outils, bien qu’ils soient conçus pour être conviviaux, nécessite une véritable formation et une réflexion critique. Le logiciel, aussi puissant soit-il, ne peut remplacer l’architecte ou l’ingénieur dans la prise de décision.

Ce phénomène est particulièrement visible à travers ce que l’on appelle “l’effet Voronoi”, qui désigne la tendance à utiliser ces programmes uniquement pour créer des motifs décoratifs à l’apparence paramétrique, sans véritable qualité architecturale ou spatiale. Ce qui est réellement fondamental, c’est la capacité à comprendre et maîtriser les principes qui sous-tendent la forme architecturale, en établissant des relations complexes entre des éléments hétérogènes. Grasshopper, par exemple, n’est ni une boîte magique ni une extension des capacités humaines. Il ne permet pas de concevoir quelque chose que l’on ne pourrait pas déjà imaginer et dessiner sur une simple feuille de papier. Ainsi, les limites ne résident plus dans le logiciel lui-même, mais dans la manière dont l’utilisateur choisit d’aborder un problème.

6 STORIA DEL COMPUTER

L’avvento del computer ha determinato un fenomeno del tutto simile alla rivoluzione industriale. Al giorno d’oggi ognuno ha a disposizione almeno un computer, uno smartphone o un tablet, i quali danno accesso globale ad un’enorme potenza di calcolo, se paragonata alle prestazioni dei primi costosissimi calcolatori. In architettura questo stravolgimento sta avendo un grande impatto, ma iniziò a cambiare il modo con cui ci approcciamo alle costruzioni già dagli anni ’60, periodo in cui i maggiori studi di progettazione tentarono i primi esperimenti informatici.

Ivan Sutherland è considerato il pioniere dei moderni sistemi CAD(Computer-Aided Design) grazie alla creazione, nel 1963, di Sketchpad, un programma per computer, il primo ad avere un’interfaccia grafica, che permetteva di disegnare parametricamente, cioè mantenendo integre le relazioni fra gli oggetti, anche dopo modifiche dell’ultimo momento.

Da questi anni in poi, studi come Skidmore, Owings &Merrill iniziarono a sperimentare un approccio digitale all’architettura. Allora tuttavia, la scarsa potenza di calcolo e il costo proibitivo dei calcolatori non permise la larga diffusione di queste macchine. Nonostante vi fossero già esemplari di computer definibili “personal”, fu IBM nel 1981 a lanciare sul mercato il primo vero Personal Computer di successo, grazie ad un prezzo accessibile e molti accessori disponibili.

Nel 1988 nasce il primo vero software di modellazione parametrica, Pro/ENGINEER, conosciuto ora come PTC Creo, il quale permetteva di modellare definendo le relazioni tra i vari elementi, la loro funzione e la loro dimensione, mantenendo integro il modello di studio virtuale; con questi software il computer non è più solo un tecnigrafo digitale, ma una macchina in grado effettivamente di accelerare il processo di progettazione e di fornire utili informazioni al designer senza la necessità di produrre modelli strutturali fisici o effettuare prove empiriche. Negli anni ’90 Microsoft ed Apple rilasciano i primi sistemi operativi con interfaccia grafica semplice ed accessibile a tutti. Da questo momento in poi il computer inizierà a diventare uno strumento essenziale per molti, dando inizio alla vera e propria rivoluzione informatica.

Architetti come Frank Gehry, Ben Van Berkel e Lars Spuybroek iniziano a basare la totalità del proprio operato sull’utilizzo del computer; inizialmente Gehry adotta il software parametrico CATIA, utilizzato fino a quel momento solo dall’industria aerospaziale, fino a svilupparne una propria versione, ad hoc per la progettazione architettonica, creata dalla propria società Gehry Technologies che venne chiamato Digital Projects. L’unica barriera alla diffusione del pc in ambito architettonico e soprattutto nell’ambito dell’architettura parametrica, era ancora la necessità di conoscere e studiare complessi linguaggi di programmazione per creare modelli funzionanti e sviluppare algoritmi generativi (come quelli di Eisenman ma codificati in linguaggio di programmazione), senza dover scendere a compromessi con le difficoltà tecniche.

Nel corso degli anni ’90 il mondo dei linguaggi di programmazione, che offrono libertà creativa teoricamente illimitata, vedono la nascita di molti linguaggi di programmazione come Python e Java che sono ritenuti più semplici da programmare ma non meno potenti. La grande novità nel campo dei software utilizzati in architettura è la comparsa nel 2003 del primo programma di “Visual Scripting” Generative Components. Esso permise per la prima volta di lavorare su operazioni e algoritmi personalizzati senza conoscere un linguaggio di programmazione. Tramite l’associazione Input-Output visuale di “blocchetti” contenenti righe di codice basilari, è possibile sviluppare un algoritmo generativo perfettamente funzionante senza conoscere a fondo i linguaggi di programmazione.

Nel 2007 esce “Explicit History”, il predecessore dell’attuale “Grasshopper”, uno dei più apprezzati software di Visual Scripting. La liberazione dalla necessità di conoscere la programmazione permette con un piccolo sforzo di gestire enormi quantità di dati, complicati processi di ottimizzazione parametrici e simulazioni sofisticate per generare forme architettoniche.

Tuttavia, grazie alla relativa facilità d’uso di questi nuovi software, si sta verificando un fenomeno di spersonalizzazione dell’architettura, oggetto di fortissime critiche, dovuto al massiccio uso di questi programmi, i quali, per quanto possano sembrare User-Friendly, necessitano comunque di una buona preparazione e della consapevolezza che il computer ed il software hanno solamente capacità di calcolo e non possono sostituire l’architetto o l’ingegnere nel processo decisionale. Molto spesso infatti si assiste ciò che viene definito “Effetto Voronoi”, ossia la tendenza riduttiva ad utilizzare questi software per creare mere decorazioni dall’aspetto “parametrico” ma senza alcuna qualità spaziale o architettonica. << Ciò che risulta realmente indispensabile è la capacità di indagare e controllare le logiche che stanno dietro la forma riuscendo a sviluppare relazioni complesse tra elementi eterogenei. Grasshopper non è una scatola magica o una protesi in grado di estendere le nostre capacità. Il suo utilizzo non ci consente di realizzare nulla che non siamo in grado di immaginare e definire su un foglio di carta. >>. I limiti non appartengono più al software quindi, ma appartengono all’utente ed al modo con cui egli sceglie di approcciare un determinato problema.

7 LES ANNEES 90 : ARCHITECTES NUMERIQUES ET ARCHITECTURES VIRTUELLES

En 1988, Philip Johnson inaugure à New York l’exposition Deconstructivist Architecture, présentant les travaux de Frank Gehry, Daniel Libeskind, Rem Koolhaas, Zaha Hadid, Coop Himmelb(l)au, Bernard Tschumi et Peter Eisenman. Cette exposition marque le début d’un nouveau mouvement architectural : le déconstructivisme.

Issu de la philosophie radicale de Jacques Derrida, le déconstructivisme prône une remise en question des structures établies et la “dénaturalisation du naturel”. En architecture, il s’agit du dernier mouvement officiellement reconnu, né en réaction aux théories postmodernes. Il privilégie des formes plastiques guidées par le chaos, refusant la géométrie traditionnelle, les axes de symétrie et les plans ordonnés. Inspiré du constructivisme russe, il rejette la pureté formelle du modernisme et propose des structures qui semblent se tordre, défiant les matériaux et les conventions architecturales.

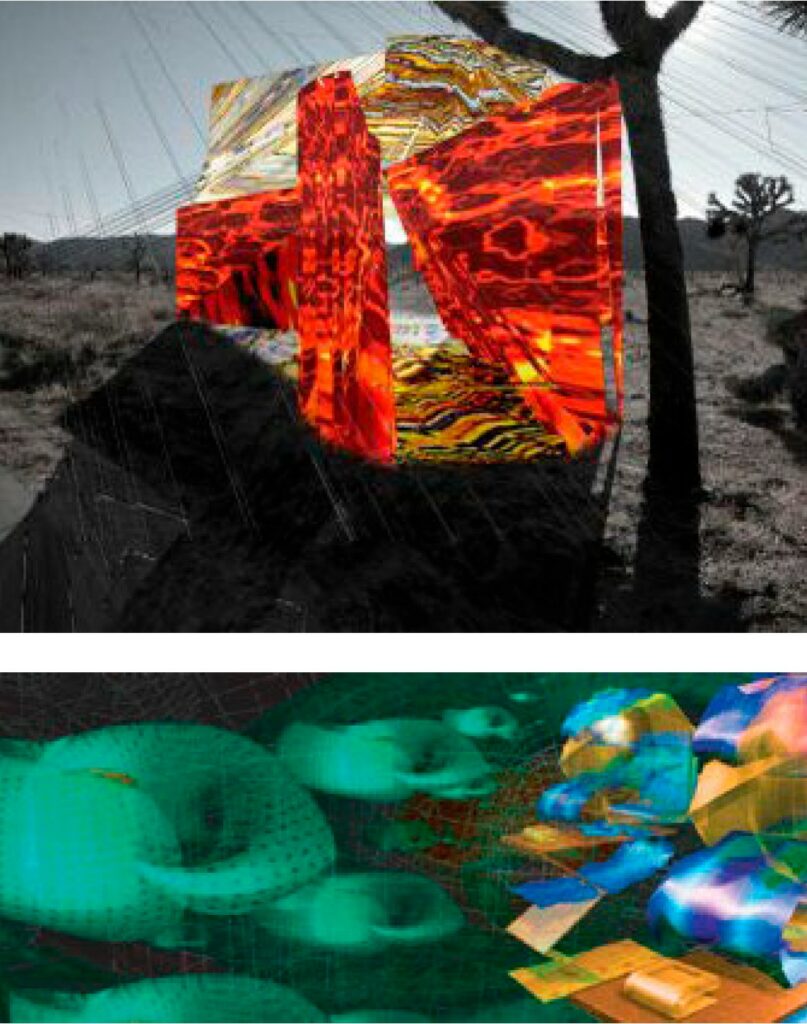

De ce mouvement émergent de nouvelles tendances cherchant à moderniser l’architecture et à dépasser la tradition, notamment l’architecture paramétrique. Dans les années 1990, plusieurs studios d’avant-garde explorent les technologies numériques pour générer et optimiser leurs projets. Parmi eux, on retrouve dECOi de Marc Goulthorpe, le groupe NOX de Lars Spuybroek, Asymptote Architecture Studio de Hani Rashid et Lise Ann Couture, Objectile Group de Bernard Cache, UNStudio de Ben Van Berkel et le groupe FORM de Greg Lynn.

Le groupe NOX vise à “libérer” l’architecture de ses propres contraintes en exploitant les technologies numériques au-delà de leur simple rôle d’outil. En témoigne la Son-o-House (2000) à Breugel, où une structure paramétrique est combinée à un système informatique de capteurs générant une symphonie en temps réel selon les mouvements des visiteurs, qui deviennent ainsi des éléments architecturaux actifs. En 2003, la D-Tower, à la fois tour et sculpture, pousse plus loin l’intégration de l’architecture et de l’informatique. Sa structure, constituée d’une membrane de verre et d’un éclairage LED intérieur, change de couleur en fonction des réponses à un questionnaire en ligne, reflétant ainsi l’émotion dominante des habitants. Ce projet soulève cependant des questions sur la durabilité des œuvres architecturales interactives, car le site web associé, fondé sur des technologies obsolètes, n’est plus accessible aujourd’hui.

Un autre exemple marquant est la Embryological House (1997-2001) de Greg Lynn, qui explore la manière de préserver et de maintenir un projet entièrement numérique. Le Centre Canadien d’Architecture conserve actuellement les modèles physiques et fichiers du projet, cherchant à garantir leur pérennité en les convertissant dans des formats open-source moins susceptibles d’être rendus obsolètes. La maison, au design organique en “blob”, repose sur douze points de contrôle définissant des milliers de configurations possibles. Ces variations sont traduites en plus de 3 000 panneaux optimisés pour une fabrication assistée par des machines à commande numérique, introduisant ainsi le concept de “personnalisation de masse” en opposition à la production de masse traditionnelle.

Fondé en 1991, dECOi Studio, dirigé par Marc Goulthorpe, joue également un rôle clé dans le développement de l’architecture paramétrique. Son approche expérimentale se reflète notamment dans l’Hyposurface (1999), une installation pour le Birmingham Hippodrome Theatre. Plutôt que de concevoir un design figé, Goulthorpe définit des contraintes à l’intérieur desquelles la forme se génère elle-même. Ce processus repose sur des “champs de forces” numériques interagissant avec les visiteurs, déformant une surface élastique modélisée mathématiquement pour produire des formes en perpétuelle mutation. Cette méthode allie à la fois rigueur algorithmique et flexibilité créative, générant ce que Goulthorpe appelle une “précise indétermination”.

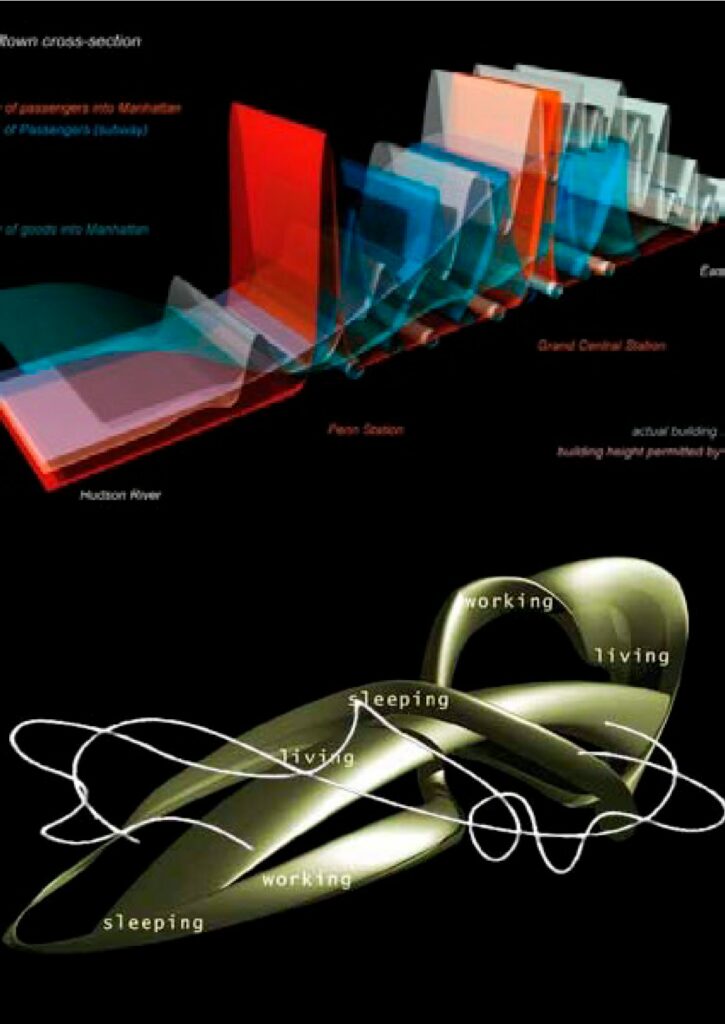

UNStudio (United Network Studio), fondé en 1988 par Ben Van Berkel et Caroline Bos, s’inspire des travaux de Peter Eisenman et développe un concept de diagramme comme outil de conception architecturale. Contrairement à Eisenman, UNStudio intègre pleinement l’outil numérique dans le processus de création, permettant d’explorer et d’analyser différentes alternatives de conception à travers des représentations dynamiques.

D’autres artistes et architectes exploitent également l’informatique et les algorithmes pour développer des architectures expérimentales. Marcus Lutyens et Tania Lopez Winkler, par exemple, conçoivent Second Skin, un projet où un algorithme génétique projette des modèles architecturaux en réalité virtuelle à partir d’informations extraites du subconscient de volontaires sous hypnose.

Enfin, Marcus Novak explore les “non-lieux” numériques en créant des architectures et des villes “liquides” dans le cyberspace. Ces structures en perpétuelle transformation passent de l’hyperespace au monde tridimensionnel, se manifestant sous forme d’isosurfaces ou de nuages de points. Ses expérimentations illustrent l’évolution des architectures numériques vers des formes dématérialisées et dynamiques, remettant en question les limites traditionnelles de la conception architecturale.

7 ANNI ’90: ARCHITETTI DIGITALI ED ARCHITETTURE VIRTUALI

Nel 1988 Philip Johnson inaugurò la mostra di New York intitolata ‘Deconstructivist Architecture’, in cui espose lavori di Frank Gehry, Daniel Libeskind, Rem Koolhaas, Zaha Hadid, Coop Himmelb(l)au, Bernard Tschumi e Peter Eisenman, gettando di fatto le basi per un nuovo movimento architettonico: il Decostruttivismo.

La teoria da cui nasce il movimento è la moderna filosofia radicale di Jacques Derrida, il Decostruttivismo, secondo cui << la decostruzione è la denaturalizzazione del naturale >> che si traduce in un approccio che non è soggettivo rispetto alla materia di indagine, piuttosto si tratta di qualcosa che “è sempre già iniziato” nel momento in cui se ne può prendere atto8.In architettura il Decostruttivismo rappresenta l’ultimo movimento “ufficiale”, nato in risposta alle teorie post moderne, assumendo forme plastiche il cui elemento ordinatore è rappresentato dal caos. Si tratta di un’architettura senza geometria, nella quale sono assenti gli elementi fondamentali, i piani geometrici e gli assi di simmetria, generando forme che si avvolgono su loro stesse instabilmente, deviando dai canoni estetici tradizionali e torcendo fino al limite i materiali da costruzione. Ispirandosi al movimento russo del Costruttivismo, rifiuta la purezza delle forme della tradizione modernista9.È da questo movimento e dal desiderio di modernizzazione e superamento della tradizione che nascono le correnti contemporanee, frale quali si può citare l’architettura parametrica, o quella che pochi anni fa venne definita “parametricismo” da Patrick Schumacher. Negli anni novanta infatti vedono la luce molti studi di avanguardia digitale che si avvalgono di tecniche di generazione ed ottimizzazione virtuali come dECOi di Marc Goulthorpe, il Gruppo NOX di Lars Spuybroek, Asymptote Architecture Studio di Hani Rashid e Lise Ann Couture, Objectile Group di Bernard Cache, UNStudio di Ben Van Berkel ed il gruppo FORM di Greg Lynn.

Il Gruppo NOX, la cui ”mission” è quella di “liberare” l’architettura dai confini che essa stessa si è creata, progetta utilizzando le più recenti tecnologie informatiche, ma senza segregarle al ruolo di semplice utensile. Nella Son-o-House del 2000 a Breugel, una struttura generata parametricamente è affiancata da un sistema di computer e sensori che creano una sinfonia in tempo reale rispondendo ai movimenti dei visitatori rendendoli elementi architettonici fondamentali. Nel2003 la progettazione della D-Tower, torre e scultura, porta al limite l’integrazione tra architettura, tecnologia ed informatica. L’installazione, composta da una membrana di vetro esterna e una serie di led all’interno, cambia colore a seconda delle risposte che i visitatori forniscono ad un questionario on line, mostrando l’emozione predominante tra i cittadini residenti e non. Il legame tra reale e virtuale è in questo caso fortissimo, ma pone anche il problema di come sia possibile mantenere sempre in funzione un tale sistema e come si debba affrontare la manutenzione di un progetto virtuale, dal momento che oggigiorno il sito internet non è più funzionante, poichè basato su tecnologie obsolete e non più supportate dai moderni browser.

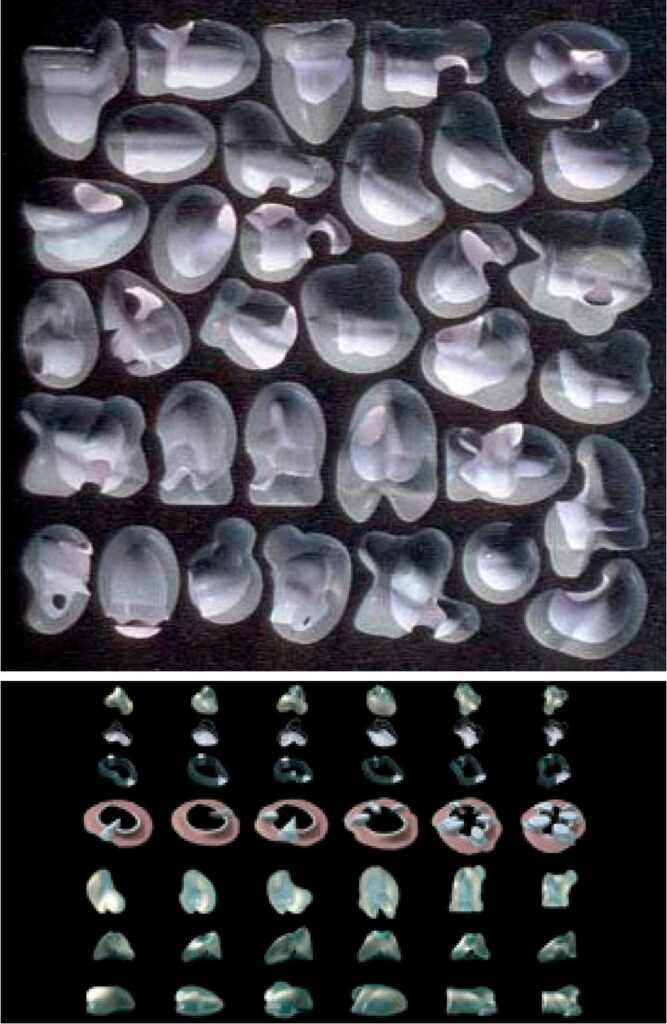

Il progetto della Embryological House (1997-2001) di Greg Lynn è un perfetto esempio di come si stiano effettuando studi su un metodo efficace per conservare e mantenere in funzione un progetto completamente virtuale. Il Canadian Centre for Architecture detiene attualmente i modelli fisici ed i file che nel complesso compongono l’interezza del progetto, indirizzando gli sforzi alla conversione ed alla manutenzione di documenti digitali che contengono file 3d e disegni cad parametrici, prediligendo formati open-source che sono meno soggetti a diventare obsoleti e quindi inutilizzabili. Il progetto è completamente parametrico e proprio grazie alla caratteristica di mantenere integre le relazioni geometriche tra gli elementi, modificabili secondo vari parametri, ha sostituito il concetto di produzione di massa in serie con quello di “personalizzazione di massa”. La casa, che presenta la tipica forma a “blob” usata da Lynn, è generata a partire da 12 punti di controllo, che possono essere spostati nello spazio a piacimento, entro certi limiti definiti, secondo un processo di morfongenesi computazionale; il loro spostamento determina migliaia di configurazioni possibili del blob, che viene di volta in volta discretizzato in più di tremila pannelli ottimizzati per la produzione tramite macchine a controllo numerico.

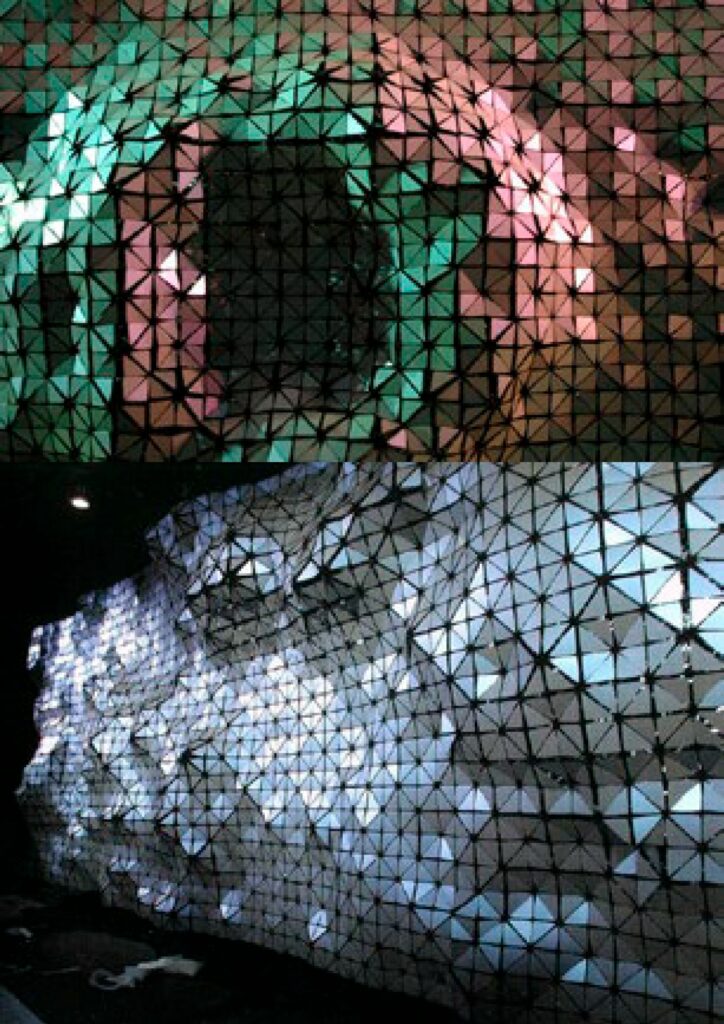

dECOi Studio, fondato nel 1991 da Marc Goulthorpe, rappresenta un ulteriore punto di riferimento per l’architettura parametrica. L’approccio non convenzionale alla progettazione ed alla definizione delle forme architettoniche si può facilmente spiegare e comprendere analizzando il progetto per l’Hyposurface, un’installazione del 1999 realizzata per il Birmingham Hippodrome Theatre. Riprendendo le parole dello stesso Goulthorpe, il loro scopo non è nel trovare il design con un gesto artistico e deterministico, ma nel porre i limiti entro i quali la forma trova sé stessa; questo processo è reso possibile creando dei campi di forza immaginari (virtuali) variabili a seconda dei visitatori, e lasciare che queste forze distorcano una superficie elastica, della quale viene creato un modello matematico per darle sostanza. Si tratta di un processo che genera una “precisa indeterminazione”, dal momento che è guidato da una logica parametrica e matematica in cui vi è sia rigore sia “rilassamento”.

UNStudio (United Network Studio), fondato nel 1988 da Ben Van Berkele Caroline Bos, lavora ancora sul concetto di diagramma derivato dalla pratica di Eisenman. Essi, per liberare l’architettura dal pericolo di ricadere nelle tipologie già esistenti, utilizzano il diagramma, il cui impiego è strettamente legato all’introduzione di concetti esterni all’architettura convenzionale, in modo da guidare il processo di progettazione attraverso multiple dimensioni, oltre le tre dello spazio, come il tempo o l’azione o l’utilizzazione.13 A differenza di Eisenman, UNStudio ha un profondo legame con l’utilizzo del computer, che viene utilizzato per generare, esplorare e infine confrontare le varie possibilità offerte dai digrammi.

Altri esempi di artisti ed architetti che fanno uso di computer, algoritmi e processi parametrici sono ad esempio Marcus Lutyens e Tania Lopez Winkler, creatori di “Second Skin”, un progetto sperimentale che utilizza un algoritmo genetico per proiettare dei modelli architettonici tridimensionali all’interno di una realtà virtuale, estrapolando informazioni dal subconscio di soggetti volontari trattati con sedute di ipnosi. Degni di nota nell’ambito della sperimentazione architettonica generativa sono gli esperimenti di Marcus Novak, che crea in un cyberspazio dei non-luoghi digitali che, mutando continuamente forma, generano architetture e città “liquide”, senza forma, e che balzano dall’iperspazio al mondo tridimensionale, risultando sia in isosuperfici sia in nuvole di punti.

8 LES ANNEES 2000 : PARAMETRICISME

Dans les années 2000, la recherche informatique continue de se développer au sein des études d’avant-garde déjà mentionnées, et un sentiment d’appartenance à un style totalement nouveau commence à émerger, un style qui va au-delà du déconstructivisme, du postmodernisme et du minimalisme. Parmi ces nouveaux acteurs, l’un des plus célèbres est Zaha Hadid Architects (ZHA), un des plus grands studios d’architecture avant-gardiste et paramétrique. Cependant, ce n’est pas la fondatrice de l’agence, Zaha Hadid, mais son collaborateur de longue date Patrick Schumacher, qui a inventé le terme “Parametricisme”, lors de la Smart Geometry Conference à Göteborg en 2007. En 2010, il publie l’essai The Autopoiesis of Architecture, qu’il considère comme le manifeste du mouvement paramétrique, définissant les “lois” devant être respectées pour revendiquer ce label.

Le parametricisme est, selon Schumacher, le style du nouveau millénaire, né au cours des quinze dernières années. Il englobe l’architecture, du design d’intérieur à l’échelle urbaine, et répond aux défis de la société en utilisant des outils paramétriques, tout en ne se limitant pas aux nouvelles techniques numériques telles que l’animation, la simulation, les outils de Form-Finding, la modélisation paramétrique et la programmation. Selon Schumacher, au-delà de toute reconnaissance esthétique, c’est la large diffusion et la forte cohérence des ambitions et problèmes de conception partagés à l’échelle mondiale qui justifient l’apparition d’un nouveau style, un phénomène épocal. Il propose de nommer ce style “Parametricisme”.

Avec ces mots, Schumacher propose un style caractérisé par la “différenciation continue”, l’”itération” et la “personnalisation de masse”, définissant des tabous et des dogmes pour ce style. Les heuristiques négatives suggèrent d’éviter les formes rigides et régulières, les juxtapositions d’éléments non corrélés et les répétitions simples. En revanche, les heuristiques positives encouragent à considérer chaque forme comme paramétriquement malléable, à différencier progressivement et à corréler systématiquement les éléments avec une complexité ordonnée. Les propositions de Schumacher ont été largement accueillies, mais également fortement critiquées pour la rigidité formelle des heuristiques, ce qui semble contradictoire avec le concept de liberté esthétique et le caractère avant-gardiste du parametricisme.

8 ANNI 2000: PARAMETRICISMO

Negli anni 2000 continua la ricerca in ambito informatico nei già citati studi avanguardisti, ed inizia a nascere un senso di appartenenza, fra molti di questi, ad uno stile del tutto differente e che va oltre al Decostruttivismo, al Postmodernismo ed al Minimalismo. Una firma tra queste, non ancora citata, è ZHA (Zaha Hadid Architects), uno dei più famosi studi di architettura avanguardista e parametrica. Tuttavia non fu la fondatrice della società a coniare il termine “Parametricismo”, bensì il suo noto collaboratore Patrick Schumacher durante la Smart Geometry Conference a Gothemburg del 2007. Nel 2010 egli pubblicò il saggio “The Autopoiesis of Architecture”, quello che egli suggerisce come manifesto del movimento parametricista e all’interno del quale sono definite le “leggi” che devono essere rispettate per potersi etichettare sotto quel nome.

Il Parametricismo è, secondo Schumacher, lo stile del nuovo millennio, sviluppato negli ultimi quindici anni, e che abbraccia l’architettura dall’Interior Design fino alla scala urbana, rispondendo alle domande della società con strumenti parametrici ma senza limitarsi alle nuove tecniche digitali introdotte (animazione, simulazione, strumenti di Form-Finding, modellazione parametrica e programmazione).

<<Oltre ed al di sopra di ogni riconoscibilità estetica, è la larga diffusione e la forte consistenza delle ambizioni/problematiche progettuali condivise globalmente a giustificare l’enunciazione di un nuovo stile, nel senso di fenomeno epocale. Noi proponiamo di chiamare questo stile: Parametricismo. >>

Con queste parole Schumacher propone il nuovo stile in chiave di “continua differenziazione”, “iterazione” e “personalizzazione di massa” definendone i taboos ed i dogmas, ossia le euristiche negative e positive. Le prime, suggeriscono di evitare forme rigide e regolari, le giustapposizioni di elementi non correlati e le ripetizioni semplici; le euristiche positive al contrario incitano a considerare ogni forma come parametricamente malleabile, differenziare gradualmente e correlare sistematicamente gli elementi con complessità ordinata. Le proposte di Schumacher sono state accolte da molti ma anche fortemente criticate per la rigidezza formale delle euristiche, in contraddizione con il concetto di libertà dai canoni estetici e con il carattere avanguardistico e di ricerca del parametricismo.